Innovations permettant de réduire l’impact environnemental

Les opérateurs de datacenter bénéficient aujourd’hui des meilleures pratiques et technologies qui n’existaient pas il y a 5 ou 10 ans. Voici quelques-unes des technologies les plus récentes qui sont déployées ou planifiées pour augmenter l’utilisation des actifs, maximiser l’efficacité, réduire les émissions et minimiser la consommation d’eau.

Gestion intelligente de l’alimentation électrique

Des équipements plus intelligents et de nouvelles commandes permettent aux opérateurs de datacenters d’améliorer l’utilisation et l’efficacité des systèmes d’alimentation critiques qui sont nécessaires pour atteindre des niveaux élevés de disponibilité des datacenters.

Une stratégie consiste à utiliser la capacité de surcharge conçue dans certaines ASI pour gérer les pics de demande courts et peu fréquents plutôt que de surdimensionner l’équipement en fonction de ces pics. Cette fonctionnalité est également utilisée pour supporter les nouvelles architectures de redondance N+1. Ces architectures utilisent la capacité de surcharge, combinée à la segmentation de la charge de travail en fonction des exigences de disponibilité, pour permettre des taux d’utilisation plus élevés des ASI tout en maintenant la redondance.

TEn mode ECO, une ASI double conversion fonctionne en mode bypass lorsque le réseau électrique fournit une alimentation acceptable, éliminant ainsi l’énergie nécessaire au conditionnement de l’alimentation, et passe en mode double conversion lorsque la qualité de l’alimentation se dégrade. Dans les modes d’exécution traditionnels du mode ECO, le disjoncteur qui bascule d’un mode à l’autre peut créer des variations de tension et des harmoniques, ce qui a limité son adoption. Une nouvelle approche, le mode online dynamique, maintient l’onduleur de sortie actif, mais ne délivre aucune alimentation lorsque l’onduleur est en bypass. Cela permet d’obtenir un rendement équivalent au mode ECO tout en minimisant les risques liés au disjoncteur entre le mode bypass et le mode double conversion.

Certaines ASI sont également dotées de fonctionnalités de support dynamique du réseau. Ces solutions pourraient jouer un rôle dans la décarbonisation en facilitant la transition vers l’énergie verte. Elles fournissent un stockage d’énergie sur site qui peut être utilisé pour compenser l’imprévisibilité des sources d’énergie renouvelable et pour revendre l’énergie excédentaire au réseau.

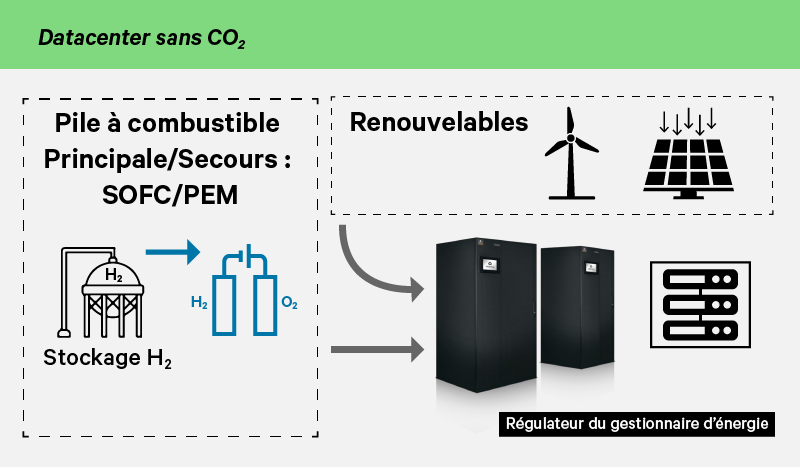

L’énergie renouvelable

L’énergie renouvelable est un moyen puissant de réduire les émissions de carbone. De multiples tactiques sont déployées pour tirer parti des sources renouvelables, y compris les PPA et les REC, et la migration des charges vers des installations de cloud ou de colocation qui se sont engagées à un fonctionnement sans carbone.

Dans un avenir prévisible, les fournisseurs d’électricité devraient être limités dans leur capacité à supporter directement les datacenters avec une énergie 100% renouvelable. Cela conduit certains opérateurs à explorer les possibilités d’alimenter les datacenters avec de l’énergie renouvelable produite localement. Cela pourrait se faire en associant des sources d’énergie renouvelables à des piles à combustible, des systèmes capables de produire de l’hydrogène propre à partir d’énergie renouvelable et des ASI dotées de fonctionnalités de support dynamique du réseau.

Voici comment cela pourrait fonctionner. L’énergie éolienne ou solaire excédentaire générée sur site est utilisée pour alimenter des hydrolyseurs qui produisent de l’hydrogène propre supportant les piles à combustible. L’énergie renouvelable alimente le datacenter pendant les périodes où la capacité de production est suffisamment forte pour le faire. Lorsque le soleil cesse de briller ou que le vent ne souffle pas et que la production d’énergie diminue, les piles à combustible alimentent le datacenter. Lorsque le carburant hydrogène est épuisé, l’ASI bascule le datacenter sur le réseau pour maintenir un fonctionnement continu.

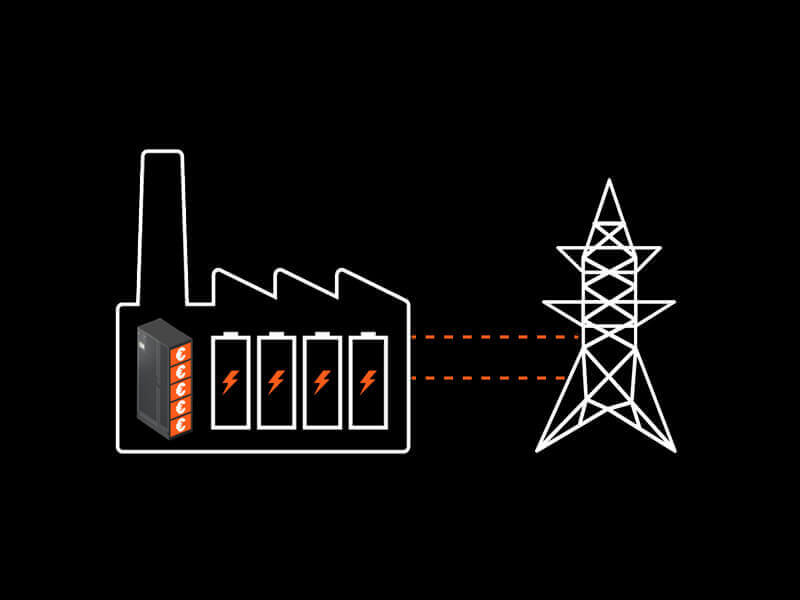

Batteries lithium-ion

Les batteries lithium-ion sont de plus en plus compétitives en termes de coût par rapport aux batteries plomb-étanche (VRLA) qui ont traditionnellement été utilisées comme source d’alimentation de secours à court terme dans les datacenters. La plus longue durée de vie fournie par les batteries lithium-ion peut signifier une fiabilité accrue et se traduit par moins de remplacements de batteries, ce qui réduit les déchets électroniques. Les batteries lithium-ion pourraient également jouer un rôle dans la transition vers les énergies renouvelables. Associées à des ASI dotées de fonctionnalités de support dynamique du réseau, elles offrent la possibilité de revendre l’énergie excédentaire au réseau, ce qui permet aux opérateurs de dégager des revenus supplémentaires de la production d’électricité sur site.

Refroidissement économe en eau et en énergie

Les systèmes de refroidissement sont généralement les plus gros contributeurs au PUE des datacenters, et des ressources importantes ont été déployées pour réduire leur impact sur le PUE en utilisant des technologies de refroidissement plus économes en énergie. Cela s’est traduit par une utilisation accrue des systèmes de refroidissement à forte consommation d’eau qui augmentent le rendement du refroidissement en utilisant de l’eau pour augmenter le nombre d’heures pendant lesquelles le système de refroidissement peut fonctionner en mode freecooling.

Les systèmes de freecooling à eau glacée parviennent à un équilibre entre l’utilisation de l’eau et l’efficacité énergétique. Ces systèmes économes en eau peuvent réduire les émissions indirectes lorsqu’ils sont supportés par des stratégies d’optimisation telles que l’augmentation des températures de l’air et de l’eau, le contrôle au niveau du système et l’ajout de technologies adiabatiques. Pour les régions où la disponibilité de l’eau est limitée ou lorsque les opérateurs ont fixé un objectif de zéro utilisation d’eau dans le cadre de leurs objectifs de développement durable, il est possible d’utiliser des systèmes à détente directe (DX) sans eau. Les systèmes de freecooling DX sont proches de l’efficacité énergétique des systèmes d’évaporation indirecte tout en éliminant les millions de litres d’eau utilisés par ces systèmes. Dans une comparaison directe des deux systèmes, les systèmes DX avec pompage de réfrigérants ont fourni un pPUE supérieur d’environ 0,01 au système à évaporation indirecte tout en réduisant l’efficacité de l’utilisation de l’eau de 0,25 pour le système à évaporation indirecte à zéro pour le système DX.

Refroidissement liquide

L’utilisation croissante de l’intelligence artificielle et d’autres applications commerciales à forte intensité de traitement exige que davantage de datacenters supportent des baies d’équipement IT avec des densités de 30 kilowatts (kW) ou plus. Cette tendance peut limiter la capacité d’optimiser l’efficacité lorsque des technologies de refroidissement par air sont utilisées pour l’évacuation de la chaleur, car le refroidissement par air devient moins efficace à mesure que la densité des racks augmente.

Ces solutions peuvent améliorer les performances des baies à haute densité en éliminant ou en minimisant l’étranglement thermique des vitesses d’horloge tout en réduisant potentiellement les coûts énergétiques des datacenters par rapport à la prise en charge des mêmes baies à haute densité avec un refroidissement par air.Les technologies de refroidissement liquide et l’infrastructure qui les supporte sont intégrées dans les datacenters existants refroidis à l’air, sont utilisées dans les datacenters HPC (High Performance Computing) entièrement refroidis par liquide et permettent la mise en place de modules de datacenter refroidis par liquide de forte puissance et entièrement confinéspour l’Edge Computing. Trois types de refroidissement liquide sont en cours de déploiement.

Les échangeurs thermiques à porte arrière amènent le liquide à l’arrière du rack plutôt que directement vers les serveurs. Il s’agit d’une approche éprouvée pour tirer parti de la propriété de transfert thermique élevé des liquides pour refroidir les racks d’équipement. Ils remplacent la porte arrière du rack par un échangeur thermique liquide passif ou actif. Dans une conception passive, les ventilateurs du serveur poussent l’air à travers l’échangeur de chaleur et l’air refroidi est ensuite expulsé dans le datacenter. Dans une conception active, les ventilateurs intégrés à l’échangeur thermique complètent le débit d’air généré par les ventilateurs du serveur pour supporter une forte puissance frigorifique.

Cette technologie achemine de l’eau ou un réfrigérant directement vers le serveur pour éliminer la chaleur des composants les plus chauds tels que les CPU, les GPU et la mémoire. Le refroidissement Direct-to-chip extrait environ 80% de la chaleur du rack, tandis que la chaleur restante est prise en charge par le système de refroidissement du datacenter.

Cette technologie immerge les équipements informatiques dans un liquide non conducteur. Les ventilateurs des serveurs ne sont pas nécessaires, car le liquide est en contact direct avec l’équipement. Cette approche ne nécessite donc aucun support de la part des systèmes de refroidissement à air. L’Open Compute Project (OCP) a publié des exigences actualisées en matière de refroidissement par immersion afin d’aider les opérateurs à définir les exigences des projets de refroidissement par immersion et à garantir la sécurité des déploiements de refroidissement liquide.

Visibilité en temps réel

Une meilleure visibilité du fonctionnement favorise souvent un contrôle plus précis. L’utilisation de capteurs de température pour surveiller les températures de fonctionnement des datacenters en est un exemple.

Dans le passé, les datacenters étaient souvent exploités à des températures de 22 °C ou moins pour s’assurer que les équipements du datacenter fonctionnaient à des températures sûres. Avec une visibilité en temps réel des températures des datacenters, les opérateurs peuvent augmenter les températures plus près de la limite supérieure des directives de l’American Society of Heating, Refrigerating and Air-Conditioning Engineers (ASHRAE) de 18-21 °C pour les équipements IT. Toutes les installations ne pourront pas se satisfaire d’un fonctionnement proche de la limite supérieure, mais il est souvent possible d’augmenter les températures et chaque degré d’augmentation de la température peut générer jusqu’à 4% d’économies d’énergie.

Tirer parti de la technologie pour réduire l’impact

Les solutions technologiques qu’une installation particulière emploiera pour réduire l’impact environnemental dépendront des objectifs et des priorités définis, de l’âge des systèmes existants et des budgets. Dans la plupart des cas, les nouvelles technologies seront introduites progressivement à mesure que les systèmes existants vieilliront, et les plans devront évoluer tandis que de nouvelles solutions technologiques verront le jour.

Ressources